Histoire de l'image analogique

Aujourd’hui nous allons parler images qui bougent sur une surface plate et les dessous de cette sorcellerie.

Je me limiterai aux technologies analogiques parce que les nouvelles sont connues et même pour certaines ont été abordées la saison dernière, notamment le MPEG quand on a parlé de la compression.

Prenez une position confortable, il y aura des choses que vous saviez déjà, mais laissez-vous guider, car elle serviront de base à celles que vous ignoriez.

On va justement commencer par LA base qui servira de rappel général en remontant plus d’un siècle en arrière :

Le cinéma.

Le principe reste assez simple : 24 images sont “flashées” chaque seconde, entrecoupées de noir.

Quiconque ayant pénétré dans une cave un jour de grand soleil, a remarqué que l’œil met du temps à s’habituer à la faible luminosité.

De même, vous avez tous vu ce point blanc fixé dans votre champs de vision après une photo de famille avec un bon gros coup de flash dans la gueule.

Et c’est cette difficulté pour l’oeil à changer rapidement de luminosité ainsi que cette faculté d’incruster l’image sur la rétine, qu’on appelle la persistance rétinienne, qui permet au cinéma de donner l’illusion d’une image constante mais qui évolue avec le temps.

Au passage, même si les images étaient à 2 images/secondes, vous auriez l’impression de mouvement, vous comprendriez l’action pour peu qu’elle ne soit pas trop rapide ou qu’elle soit simple, mais on y reviendra un jour où je parlerai des sprites et autres astuces dans les vieux jeux vidéos.

De cette première technologie, on a déjà la base de tout ce qui suivra en terme d’écran et de visualisation de mouvement.

Maintenant avançons dans le temps au début du 20e siècle environ (les années 30 donc) avec...

L’écran cathodique

Le principe de base est assez génial et avancé et peut être retrouvé dans les oscilloscopes :

L’écran, la dalle face à vous qui affichera l’image est composé de petits éléments phosphorescents, appelés luminophores, qui émettent de la lumière par excitation lorsque les électrons viennent les heurter, ce qui constitue un point lumineux appelé pixel.

Le gros entonnoir en verre derrière est composé d’un canon à électrons au fond (ouais un canon à électrons!!! ça fait super futuriste dit comme ça) et d’aimants capables d’infléchir la trajectoire de ce “tir” d’électron.

Ce tir balaye la première ligne de pixel d’un côté à l’autre de l’écran, puis la deuxième et ainsi de suite jusqu’en bas de l’écran et ça recommence.

Pour afficher des niveaux de gris, c’est simple: on fait varier l’intensité du rayon, à 100% de la puissance on aura du blanc et à 0% c’est noir. Entre les deux c’est gris plus ou moins clair.

Comme pour le cinéma, ce balayage est tellement rapide que l’oeil humain ne le perçoit pas et ne voit qu’une unique image mais qui bouge.

Afin de simplifier la conception des téléviseurs, la fréquence de balayage (combien de fois par seconde on balaye le même pixel) est basé sur la fréquence de l’électricité qui l’alimente.

En Europe, nous avons du 50Hz et aux USA du 60Hz.

Vous l’aurez deviné: cela donne le nombre d’image par seconde: 50 ou 60 images par seconde selon votre côté de l’atlantique. (Attention, on parle de la fréquence de l’écran lui-même, pas celui de la télévision, j’y reviendrai après)

Et comment afficher de la couleur alors?

Là nous sommes plutôt au milieu des années 50 aux USA voir début des années 60 en Europe et 1er octobre 1967 en France

Le principe est le même, mais cette fois avec 3 canons qui produisent 3 rayons, chacun responsables d’une couleur.

L’écran, lui voit chaque pixel divisé en 3 triplets Rouge Vert et Bleu. D’où le RGB (red green blue) que vous avez peut-être croisé si vous avez fait du photoshop, du web ou autre activité informatico-colorée.

Mais revenons à l’écran couleur :

Pour éviter qu’un canon puisse allumer la mauvaise couleur, un filtre optico-mécanique, une bête grille percée de trous, un par triplet, qui est posée devant chaque tube pour n'éclairer que sa couleur.

Si les 3 triplets sont allumés, on voit du blanc, sinon on voit du rouge, du vert ou du bleu ou des combinaisons de ces couleurs primaires de la lumière.

Exemple: pour faire du jaune, on allume le rouge et le vert.

La télévision, le PAL et le SECAM

Vous vous en doutez, la télévision et les moniteurs cathodiques servant à la regarder ont été conçus pour être compatibles (sinon ça marche pas, forcément, hein)

Je vous ferai grâce pour aujourd’hui de l’explication assez technique de la transmission par modulation de signal pour me concentrer sur ce qui en a découlé et faire une grossière simplification des principes qui en ont découlé. Encore une fois c’est pas tout à fait juste mais c’est “en gros” ce qui se passe.

Transmettre 50 ou 60 images par secondes, non seulement c’est extrêmement difficile, mais en plus c’est inutile.

Petit troll: tout joueur de console vous expliquera que 30 images/seconde c’est bien assez pour jouer. Alors pour un film, vous imaginez bien que ça fera l’affaire.

Du coup, en gros, on divise la fréquence par 2:

- les 50hz deviennent 25 images par seconde en Europe

- les 60hz deviennent 30 images par seconde aux US

Le soucis c’est qu’ici, contrairement au cinéma, on n’a pas de “noir” au milieu, entre deux images. Et si on balayait à 25/30 images par seconde, on sentirait un scintillement fatiguant pour les yeux.

Alors la tricherie est d’envoyer l’image en 2 parties :

- l’image 1 balaye les lignes paires

- l’image 2 balaye les lignes impaires

Du coup on affiche 50 ou 60 demi-image/seconde.

Pas d’effet de scintillement et au final la quantité de transmission est l’équivalent de 25 ou 30 images/s

Comme la physique reste la même dans et en dehors de l’Europe, et qu’au final, on peut considérer qu’on envoie X pixels/seconde, la fréquence européenne, plus basse, permet d’afficher un nombre de lignes supérieur.

- 625 pour les standards PAL et SECAM (Europe)

- 525 pour le standard NTSC en usage au Japon, États-Unis et Canada.

Voilà la base qui explique pourquoi deux standards et autant d’incompatibilités.

Je ne suis pas rentré dans le codage du signal mais en voici le principe général :

Un signal vidéo est un signal d’1V maxi de haut constitué de plusieurs parties :

- l'information de Luminance

- la synchronisation ligne, (une impulsion, un “top”)

- l'information de chrominance (restitution de la couleur),

- un "burst" de synchronisation pour la sous porteuse chrominance, des informations de synchronisation trame dans certaines lignes.

On voit donc que la couleur est envoyée à part du reste de l’image et cela permet notamment la compatibilité avec des téléviseurs noir et blanc mais cela explique aussi pourquoi l’image est en noir et blanc quand on branche un appareil US sur une TV européenne.

Bref, retenez que la vidéo est transformée en une onde complexe.

Or, une onde, on sait très bien la stocker ! On l’a vu dans l’histoire de la Hi-Fi

Du coup, on va faire un bon dans l’histoire, arriver dans les 70s ….

La VHS

De la même manière qu’une cassette audio enregistre les perturbation de l’air sous la forme d’une onde électro-magnétique, la VHS (ou le betamax) fait de même avec le signal vidéo.

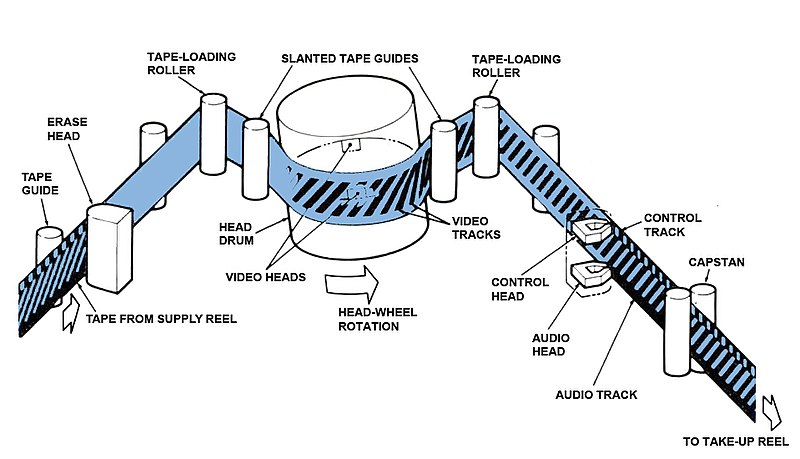

Comme on veut du son, la piste est séparée dans son usage entre les deux… ou en fait les 3 pour être exact : un des bords est utilisé pour l’audio, l’autre pour la piste de contrôle (la synchronisation, la gestion du défilement etc) et le centre pour la vidéo.

Petite particularité néanmoins:

La piste audio est enregistrée de manière linéaire, le long de la piste en fait alors que la piste vidéo, disposant de + de hauteur est enregistrée en zébras. Plein de diagonales les unes à côté des autres.

Pour ceux qui ont déjà démonté un magnétoscope, c’est pour cela qu’il y a un gros cylindre monté en travers à l’intérieur. Il comporte des 2 têtes de lecture qui se relayent pour balayer en diagonale la surface magnétique.

Il y a de l’espace entre les zébras qui laisse le temps à l’autre tête d’arriver et sert de zone tampon pour éviter les perturbations.

Et pourquoi avoir fait ça?

Deux raisons tellement imbriquées entre elles que la solution est effectivement bien vue :

- Le signal de l’image étant plus complexe que le signal audio, il fallait + de défilement de bande chaque seconde pour la vidéo que pour l’audio (on a vu la dernière fois que c’était un des paramètres pour obtenir une bonne qualité de signal) Si on reste linéaire, soit on augmente la qualité de l’audio inutilement, soit on baisse la qualité de la vidéo.

- Pour économiser de la bande magnétique. Avec cette astuce, on peut mettre + de mètre linéaire de piste par mètre de bande, il suffit de la rendre + large, et l’épaisseur de la cassette est bien moins problématique que sa longueur et la largeur

C’est cette particularité qui a donné son nom à la VHS:

Vertical Helical Scan (scan hélicoide vertical) renommé ensuite Video Home System parce que les clients ne comprenaient pas la technique (et s’en moquaient pas mal, aussi)

A part cette particularité intéressante au demeurant, on reste sur le même principe d’un signal (enfin 2 avec le son) modulé pour afficher une image. On utilise d’ailleurs toujours les mêmes normes NTSC et PAL…

Vous pensez qu’ensuite arrive le DVD et pouf, fin de la chronique ?

Mouhahaha non. Il y a, entre la VHS et le DVD, un chaînon qu’on oublie souvent

Le Laserdisc

Pour les 2-3 au fond qui ne connaitraient pas, il s’agit de disques ressemblant au CD mais de la taille d’un vinyle (30 cm de diamètre) avec deux faces lisibles.

A sa sortie, chaque face contient 30 min. Oui 30 minutes !

Vous qui trouvez que Netflix met du temps à passer d’un épisode à l’autre, dites vous que pour regarder Titanic (c’est l’époque), il fallait se lever 5 fois !!!

Début

- 30 min => tourner le disque

- 1h => changer le disque

- 1h30 => tourner le disque

- 2h => changer le disque

- 2h30 => tourner le disque

FIN

Bon, il existait des lecteurs auto-reverse qui permettait de ne se lever “que” 2 fois pendant un film de 3h, ouf !

Le signal de sortie est toujours analogique c’est littéralement le même que celui qu’on trouverait sur une VHS, en tout cas pour la vidéo.

Contrairement à ce que j’ai longtemps cru, le Laserdisc ne fonctionne pas du tout comme le CD.

Rappelez-vous, le CD, c’est une onde qui est découpée en une suite de valeurs d’intensité, 44 mille fois par seconde et qui permet d’approximer la véritable courbe du son. On aurait pu faire de même pour le Laserdisc avec le signal vidéo mais il n’en est rien.

Pourquoi ? Et bien pour commencer, parce que cette technologie n’existait pas au moment de sa conception.

Oui, le Laserdisc sorti sur le marché en 1978 est donc plus ancien que le CD, sorti 4 ans plus tard, en 1982. Et il est aussi probable que son développement a été plus long.

Les détails me passent bien au-dessus, mais voici la base :

Quand sur un CD on encode des 0 et des 1 de manière régulière avec les trous ou au contraire leur absence.

Sur un Laserdisc, la longueur des trous est variable et du coup, ce n’est pas numérique mais bien analogique.

Analogique du début à la fin, donc.

Au début, à chaque tour correspond une image et le son associé… Et là les plus vifs d’entre vous voient déjà un soucis : un tour c’est beaucoup plus petit au centre qu’à l’extérieur du disque.

Mais la vitesse angulaire est identique (le nombre de degré par seconde)

C’est pour cela qu’une deuxième version avec cette fois une vitesse linéaire constante est apparue et permettait de passer de 30 minutes par face à 60 minutes par face. (une révolution !!!)

La particularité intéressante est qu’ensuite, avec les évolutions, le son est passé d’analogique à numérique (comme le CD) mais l’image, elle est restée analogique.

Mieux: le dolby digital ou le DTS, des technologies permettant multicanal (le home cinéma si vous voulez) ont été introduites aussi sur le Laserdisc.

Il a été remplacé par les disques contenant de la vidéo compressée avec le MPEG (dont on a expliqué le principe lors de l'article sur la compression). D’abord le Vidéo-CD puis le Super Video-CD puis le DVD... Mais cela n'est plus analogique !

C’est donc là que nous avons terminé notre petit voyage dans le monde merveilleux de l’image analogique.